Land use planning involves intertemporal decisionmaking—the consideration of a subsequent decision before a first decision is made. Decisions in the urban development process include the purchase, assembly or subdivision of land; the provision of transportation, electric, water and wastewater services; the application for and approval of building permits; and the sale of improved property to final users.

The ability to analyze this process has been limited by the lack of dynamic models of development stages, time-series data on land use decisionmaking, and empirical approaches to analyzing multiple events in time and space. In part for these reasons, there has been almost no empirical evidence on the process of planning or the effects of plans on subsequent development.

To gain new insights into the effects of planning on the urban development process, we have developed theoretical models of urban planning, constructed a dynamic geographic information system, and developed computer algorithms for interpreting and displaying urban development events. The information system is characterized by a high degree of spatial and temporal resolution and the ability to observe development activity over time.

As a result, the information system facilitates the observation of spatial and dynamic processes that characterize urban development, the formation and testing of hypotheses about such processes, and the exercise of high-resolution simulations based on statistically confirmed relationships.

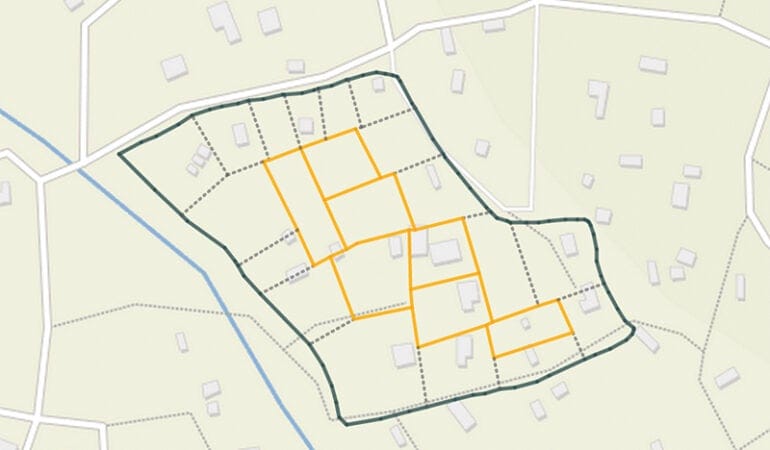

Study Site on Portland’s Westside Corridor

The information system is built upon the Regional Land Information System (RLIS) developed by Metro, the regional government of Portland, Oregon. RLIS is a comprehensive Geographic Information System (GIS) containing layers that depict tax lots and their attributes; planning designations and zoning regulations; soil, water and environmental resources; infrastructure facilities and capacities; government boundaries, tax districts and transportation zones; and census data for the entire Portland metropolitan area.

RLIS has been enhanced to include attributes of development events, such as land sales, subdivisions, and changes in plan designations and zoning. Although the system currently includes only the years 1991 to 1995, it is an unusually comprehensive, high-resolution, and dynamic research and planning tool.

To test the utility of the information system, we examined the urban development process in Portland’s Westside corridor, where a new light rail system is scheduled to begin service in 1998. Construction of the Westside segment began in 1992, and the far western station locations were finalized on July 28, 1993. When complete, the Westside line will connect the western suburbs of Hillsboro and Beaverton to downtown Portland and to the eastern sections of the light rail system.

Ambitious plans for the metropolitan area call for high-density development along Portland’s light rail corridors to contain growth within the urban growth boundary. By focusing on the Westside corridor, it is possible to evaluate whether the development decisions and transactions of land owners and local governments are influenced by anticipated light rail infrastructure investments and consistent with regional development plans.

Mapping the Development Process

The development process can be examined using dynamic geographic visualization—that is, the observation of urban development events at varying temporal and geographic scales. Using a tax-lot base map, for example, and by illuminating tax lots when certain events occur in a sequence of frames, it is possible to watch the urban development process much like a movie. The sequence of frames printed in this issue of Land Lines illustrates selected development activities from 1991 to 1995 in an approximately one-square-mile area around the proposed Orenco light rail station. Since it is difficult to reproduce the frames here, please go directly to the authors’ web page for mapping details at http://www.urban.uiuc.edu/projects/portland/lincoln.html

The first frame shows the sale of several large industrial properties in 1991, when the route of the rail line was known, but not the station location. In 1992, a demolition and construction permit was issued on a large industrial parcel. The third frame shows the station location, with development on industrial land near the station and increasing sales activity in the subdivision in the northwest corner of the study area.

The fourth frame shows that a station overlay zone was adopted in 1994. It subjected building permits in the station area to a special review process to assure that proposed developments are transit supportive. The frame also shows a marked increase in residential sales in the northwest subdivision and in the old town of Orenco in the inner southeast corner of the study area. The fifth frame shows a continuation of sales and development activity in both residential and industrial parts of the study area.

This series of frames captures an intriguing pattern of development events. First, the number of sales and permits in the study area before the announcement of the station location suggests that the station was sited in an area of active industrial development. Second, the activity in both the conventional subdivision in the northwest corner and in the township of Orenco indicates that the announcement of the station location accelerated nearby residential development activity.

Third, the demolitions approved just before and the building permits approved just after the station location was announced suggest that redevelopment of industrial land near the station is concurrent with the building of the light rail system. Such concurrency of private and public development activity is a fundamental objective of land use planning. Finally, the imposition of the interim development restrictions does not appear to have slowed the rate of development activity. In fact, the increased certainty about the regulatory environment may have increased activity.

This five-year display of development events may be unique to the Orenco station area. Certainly, previous land use plans, sewer system investments and industrial expansion patterns have influenced development in the area. Nevertheless, the ability to track parcel-by-parcel activity in the county-wide database will enable in-depth examination of the extent to which dynamic and spatial relationships between development events and land use plans are significant and pervasive.

The regional and local governments of metropolitan Portland are engaged in an extensive planning endeavor to shape the extent, location and nature of urban development over the next four decades. As implementation proceeds, the information system will enable us to monitor the planning, regulation and development process and, for at least this metropolitan area, assess whether and how planning matters.

__________________

The authors are affiliated with the Department of Urban and Regional Planning at the University of Illinois at Urbana-Champaign. Chengri Ding is a post-doctoral fellow specializing in the use of geographical information systems for urban economic analysis. Lewis Hopkins is professor and head of the department. Gerrit Knaap is associate professor, currently on sabbatical as a visiting fellow at the Center for Urban Policy and the Environment at Indiana University and a senior research fellow at the American Planning Association. Support for their research has been provided by the Lincoln Institute of Land Policy; the University of Illinois Research Board; the Metro of Portland, Oregon; Washington County, Oregon; the Tri-county Transportation District of Portland, Oregon; and the National Science Foundation.

The development of new land and tax systems in countries in political and economic transition in Central and Eastern Europe reflects a unique array of historical, social, political, and economic circumstances. While all transitional countries seeking admission to the European Union (EU) have initiated comprehensive reforms to encourage free markets and democratic governments, the three Baltic nations—Estonia, Latvia, and Lithuania—made privatization and restitution of property rights a prime objective immediately after their independence in the early 1990s. These actions, together with a desire to stimulate real estate markets and capture tax revenues for improved public services, made them the first of the transitional countries to introduce value-based taxation of real property.

Universal high-speed Internet access is a popular dream these days—everyone from the president to Google, Inc., has embraced it. And the tech press is full of testy critiques wondering why typical broadband speeds in the United States lag so far behind those in, say, South Korea.

Just five years ago, this wasn’t such a hot topic. Back then, the discussion—and action—wasn’t led by the federal government or the private sector. The first movers were a number of diverse but forward-thinking municipalities: cities and towns like Chattanooga, Tennessee; Lafayette, Louisiana; Sandy, Oregon; and Opelika, Alabama.

Motives and solutions varied, of course. But as high-speed connectivity is becoming recognized as crucial civic infrastructure, Chattanooga makes for a useful case study. Its journey to self-proclaimed “Gig City” status—referring to the availability of Internet connections with 1 gigabit-per-second data transfer speeds, up to 200 times faster than typical broadband speed for many Americans—started with visionary municipal initiative, built upon via thoughtful private and public coordination. Most recently, this effort has even begun to show tangible effects on city planning and development, particularly in the form of an in-progress reimagining of a long-sleepy downtown core. In short, Chattanooga is starting to answer a vital question: once a city has world-class Internet access, what do you actually do with it?

The story begins more than a decade ago, when Chattanooga’s city-owned electric utility, EPB, was planning a major upgrade to its power grid. Its CEO, Harold Depriest, argued for a plan that involved deploying fiber-optic cable that could also be used for Internet access. After clearing local regulatory hurdles, the new system was built out by 2010, and every EPB power customer in the Chattanooga area—meaning pretty much every home or business—had gigabit access. But you had to pay for it, just like electricity. And the early pricing for the fastest access was about $350 a month.

“They had very, very few takers,” recalls Ken Hays, president of The Enterprise Center, a nonprofit that since 2014 has focused, at the behest of local elected officials, on strategizing around what Chattanoogans call “the gig.” The head of Lamp Post Group, a successful local tech-focused venture firm, made a point of signing up immediately, Hays continues. But on a citywide level, “we didn’t have the excitement” that talk of gig-level access generates today. And in 2010, he adds, “there weren’t many good case studies out there.”

But broader change was afoot. The announcement of Google Fiber—the Internet search giant’s foray into building out high-speed online infrastructure—sparked new interest. And in 2013, Jenny Toomey, a Ford Foundation director focused on Internet rights, helped organize a summit of sorts where officials from municipalities like Chattanooga, Lafayette, and elsewhere could meet and compare notes. “It was still pretty nascent at the time,” recalls Lincoln Institute President and CEO George W. McCarthy, an economist who was then director of metropolitan opportunity at the Ford Foundation. But that summit, he continues, helped spark new conversations about how such initiatives can make cities more competitive and more equitable, and less reliant on the purely private-sector solutions we often assume are more efficient than government. “And over the course of two years since, this issue has just exploded,” he says.

In fact, that summit turned out to be the rare event that actually spawned a new organization: Next Century Cities, founded in 2014, now has more than 100 member municipalities. They share best practices around an agenda that treats high-speed Internet access as a fundamental, nonpartisan infrastructure issue that communities can and should control and shape.

Against this backdrop, Chattanooga was taking steps to demonstrate how “the gig” could be leveraged. The Lamp Post Group had moved into downtown space, and superlative Internet access was just a starting point for the young, tech-savvy workers and entrepreneurs it wanted to attract. “If we don’t have housing, if we don’t have open space, if we don’t have cool coffee shops—they’re going to go to cities that have all that,” says Kim White, president and CEO of nonprofit development organization River City Company.

Starting in 2013, a city-center plan and market study conducted by River City proposed strategies to enhance walkability, bikeability, green space, and—especially—housing options. More than 600 people participated in the subsequent planning process, which ultimately targeted 22 buildings for revitalization (or demolition). Today, half of those are being redeveloped, says White, and more than $400 million has been invested downtown; in the next year and a half, 1,500 apartments will be added to the downtown market, plus new student housing and hotel beds. The city has provided tax incentives, some of which are designed to keep a certain percentage of the new housing stock affordable. The city has also invested $2.8 million in a downtown park that’s a “key” part of the plan, White continues, to “have areas where people can come together and enjoy public space.” One of the apartment projects, the Tomorrow Building, will offer “micro-units” and a street-level restaurant. “I don’t think we would have attracted these kinds of businesses and younger people coming to look,” without the gig/tech spark, White concludes. “It put us on the map.”

The gig was also the inspiration for a city-backed initiative identifying core development strategies that led to the Enterprise Center pushing a downtown “innovation district,” says Hays. Its centerpiece involves making over a 10-story office building into The Edney Innovation Center, featuring co-working spaces as well as the headquarters of local business incubator CO.LAB. The University of Tennessee at Chattanooga has a project involving a 3D printer lab in the Innovation District, and even the downtown branch of the Chattanooga Public Library has been made over to include a tech-centric education space.

EPB, whose original fiber-optic vision set the Gig City idea in motion, has long since figured out more workable pricing schemes—gig access now starts at about $70 a month—and drawn more than 70,000 customers. More recently, it has also offered qualified low-income residents 100-megabit access, which is still much faster than most broadband in the U.S., for $27 a month. And its efforts to expand into underserved areas adjacent to Chattanooga have become an important component of broader efforts to challenge regulations in many states, from Texas to Minnesota to Washington, that effectively restrict municipalities from building their own high-speed access solutions.

In short, a lot has changed—in Chattanooga and in other cities and towns that have pushed for Internet infrastructure that the private sector wasn’t providing. “Most of this work right now is happening at the local level,” says Deb Socia, who heads Next Century Cities. “It’s mayors and city managers and CIOs taking the steps to figure out what their city needs.” The implications for crucial civic issues from education to health care to security are still playing out. And precisely because the thinking and planning is happening on a municipal level, it won’t be driven solely by market considerations that favor what’s profitable instead of what’s possible. “The beauty of it is,” McCarthy summarizes, “it’s a both/and argument.”

Rob Walker (robwalker.net) is a contributor to Design Observer and The New York Times.

In four years, there will be a fresh count of Americans. The 2000 Census will reveal how many of us there are, who we are in terms of race, nativity, income, family size and occupation, what kind of housing we occupy, where we live and where we work.

All these numbers, but especially the latter two, will reflect what is happening to what planners and social scientists call settlement patterns. The Census will show how people and jobs are distributed regionally between North and South and East and West; within regions between metropolitan and non-metropolitan areas; and within metropolitan areas between cities and suburbs.

Settlement patterns have been transformed radically in the twentieth century (see graph 1). On a regional basis, the trend has been from East to West and North to South. In the decade between 1980 and 1990, for example, three states in the West and South accounted for 50 percent of the nation’s population growth: California, Florida and Texas.

Within all regions, the trend has been toward ever larger metropolitan agglomerations. By 1990, metropolitan areas of 1,000,000 or more accounted for 50 percent of the nation’s population. Within metropolitan areas, cities grew faster than suburbs at the beginning of the century, but by the 1950s the trend was sharply in favor of the suburbs, which now account for more than half of the nation’s population.

Will the 2000 Census confirm the continuation of these trends? What stakes do we have in the outcome? Quite a few. We worry about trends that erode the economic base of cities because we are concerned about job opportunities for the poor who are committed, by choice or circumstance, to live in the city. We are also concerned about the health of the tax base, which affects the capacity of the local government to deal with the needs of all its residents.

We also worry about land use patterns in the suburbs which both require and increase auto-dependency. This trend in turn leads to more auto travel, aggravates congestion, pollutes the air, and complicates our international relations because of our heavy dependence on imported oil.

We are in the throes of a revolution comparable in scope to the revolution in transportation technology that heavily influenced settlement patterns in the nineteenth and twentieth centuries. The transportation revolution, from ships and trains to cars and planes, made it possible for both workers and their employers to have a wider choice of locations.

The pace of the revolution in data processing and communications, which began slowly in the middle of the twentieth century, has quickened rapidly in recent years. We speak of a post-industrial information economy. By that we mean that information constitutes an ever-increasing share of the Gross National Product, both as “input” to the production of other goods and services and as “output” in the form of entertainment and related activities.

Household Location Decisions

How will settlement patterns be affected by the transition to an information economy? Let us first consider the worker’s choice of a residential location. In classical urban economics, this choice is seen as a “trade-off” between the merits of a particular place in terms of quality of life and the cost of commuting to work. As the transportation revolution reduced the time and money costs of commuting, more and more workers were able to afford to locate in what they considered an attractive suburb that offered the lifestyle they preferred: a private home with a lawn, good schools, parks and open space, shopping facilities, and friendly neighbors.

The New York Times of July 14, 1996, reports that because of the revolution in communications and data processing, accompanied by company downsizing, as many as 40 million people work at least part time at home, with about 8,000 home-based businesses starting daily.

Logic suggests that some of this new-found workplace freedom will manifest itself in location choices that favor places considered desirable, be they in the farther reaches of suburbia, exurbia, or rural America. On the other hand, if these dispersed self-employed workers end up commuting less, their freedom may not “cost” the society more in terms of congestion and pollution.

Business Location Decisions

What about the conventional company and its location decisions? Like the household, the company does a “balancing” act when it chooses a location. From the perspective of product distribution, Place A might be preferred. From the perspective of the inputs of materials, Place B might be ideal. From the point of view of labor costs, Place C might be best. For tax purposes and related “public” issues, Place D might be most beneficial.

If the entire company has to be in one place, then compromise is inevitable. But if the communications revolution permits the “dis-integration” of the company via the physical separation of functions or the “outsourcing” of particular functions, then what used to be one location decision becomes a multiplicity of decisions, each component responding to a compelling argument for a particular place.

The classic example is the “front” office of a bank or insurance company in the midst of a congested city center with the “back” office in a rural area in another region or even in another country.

Settlement Trends

How these changes in household and business location choices will ultimately affect settlement patterns in metropolitan America was the subject of a major study by the Office of Technology Assessment (OTA), an agency that served the U.S. Congress for many decades but was abolished by the Congress in 1995. The summary chapter in The Technological Reshaping of Metropolitan America states that “technology is connecting economic activities, enabling them to be physically farther apart, reducing the competitive advantage of high-cost, congested urban locations, and allowing people and businesses more (but not total) freedom to choose where they will live and work.”

But OTA concludes that “the new wave of information technologies will not prove to be the salvation of a rural U.S. economy that has undergone decades of population and job loss as its natural resource-based economy has shrunk.” Rather, most economic activity will locate in large and medium-sized metropolitan areas (see graph 2).

“Technological change. . .threatens the economic well being of many central and inner cities, and older suburbs of metropolitan areas,” the report continues. Overall, the trends suggest that these places will find it hard to compete without economic development policies designed to offset their competitive disadvantages.

In short, the OTA expects that, the communications revolution notwithstanding, the 2000 Census will report a continuation of the trends manifested throughout the latter half of the twentieth century. The favored locus of activity in both residential and business terms will be the outer suburbs of metropolitan areas. Given our concerns with the adverse effects of prevailing settlement patterns, the challenge to land policy is greater than ever.

______________

Benjamin Chinitz is an urban economist who served as director of research at the Lincoln Institute from 1987 to 1990. He continues to serve as a faculty associate at the Institute and as visiting professor in urban and regional planning at Florida Atlantic University.

Thomas Horan is director of Applied Social and Policy Research at Claremont Graduate School in Claremont, CA.

A major tragedy of empirical work is the low ratio of analysis to data, in part due to the lack of publicly available datasets. Many data collectors are reluctant to share data with other researchers until they have harvested all its new insights. Accordingly, researchers often collect new data because they cannot access existing information.

A new initiative of the Lincoln Institute is to compile data relevant to the analysis of land and tax policy, make it available on our Web site, and encourage new research. Three very different datasets are currently available, and a fourth is under development.

Significant Features of the Property Tax. This database title refers to the well-known publication, Significant Features of Fiscal Federalism, produced by the Advisory Commission on Intergovernmental Relations, which between 1959 and 1996 reported on the relationships among local, state, and national levels of government. This online and interactive database, produced and continually updated in partnership with the George Washington Institute of Public Policy, presents property tax data for all 50 states

Great care is taken to ensure that data reported across jurisdictions are comparable and similarly defined. Users may access property tax information and data online in standard tables or create new downloadable tables containing the specific data they seek. Unlike many interactive databases, Significant Features also includes many table entries in text that explain, for example, how each state categorizes property, defines taxable value, and restricts or caps rates and assessments.

Land and Property Values in the U.S. These more traditional tabular files contain numeric data on the values and rents of residential properties in the United States. The national ratio of rents to prices for the stock of all owner-occupied housing is available quarterly from 1960 to the present. National indices of prices and values of housing (land inclusive of structures), land, and structures are available quarterly from 1975 to the present and annually from 1930 to the present. For 46 metropolitan areas, quarterly indices of prices and values of single-family, owner-occupied housing (land inclusive of structures), land, and structures are available from 1985 to the present.

The implicit rents of owner-occupied housing, the value of structures, and the value of residential land are rarely observed directly, and therefore are estimated using techniques that are explained on the Web site. These data were created and are updated by Morris A. Davis, a fellow at the Lincoln Institute and faculty member at the University of Wisconsin School of Business, Department of Real Estate and Land Economics.

University Real Estate Development Cases. Many university real estate development projects involve the expansion of facilities, the upgrading of neighboring properties, and long-term investment in real estate. Such projects are often controversial when they displace current residents and businesses or transform neighborhoods. As part of the Lincoln Institute’s research on town-gown issues, this database presents quantitative and qualitative information on 897 projects that are outside traditional campus boundaries. These cases provide a useful composite picture of recent university real estate activities.

Digital Maps of Urban Spatial Extension. Visiting fellow Shlomo Angel is examining the spatial growth of a sample of global cities and has created a set of digital maps derived from satellite data and historic sources. Focusing on measures of developed versus undeveloped land, the maps form the basis for several Lincoln Institute working papers on the spatial growth of cities over time. The maps will exist as digital files that can be downloaded and analyzed by others who want to pursue related work.

These datasets are the Lincoln Institute’s first steps toward increasing the availability of data to researchers, analysts, policy makers, and concerned citizens with an interest in land policy and taxation. The information is freely accessible on the Tools and Resources section of the Institute Web site at www.lincolninst.edu.

El precio de la vivienda está subiendo en espiral en muchas áreas de los estados unidos, limitando la capacidad de los estadounidenses para ahorrar, y llevando al aburguesamiento a barrios que antes eran asequibles. No obstante, como con muchos desafíos de política pública, no siempre se puede determinar a simple vista dónde se encuentran los problemas más graves. A Helen Campbell, una analista del Departamento de Vivienda e Inversión Comunitaria de Los Ángeles, esto le quedó muy claro un viernes por la tarde en el mes de julio. Una solicitud de información de la oficina del alcalde la llevó a descubrir que gran parte de los inquilinos del Valle de San Fernando en Los Ángeles pagaban el precio de alquiler de vivienda más alto de todo el país, que el Departamento de Vivienda y Desarrollo Urbano de los EE.UU. (U.S. Department of Housing and Urban Development, HUD) define como la situación en la que las familias destinan más del 30 por ciento de sus ingresos al alquiler de su vivienda.

Los funcionarios de Los Ángeles sabían que había zonas donde los propietarios e inquilinos tenían dificultades para pagar la vivienda, dice Campbell, pero no tenían idea de cuán grave era la situación e incluso dónde era más acuciante. La oficina del alcalde necesitaba datos fidedignos sobre esta evolución preocupante para poder solicitar el mantenimiento del Programa HOME de Sociedades de Inversión, el mayor programa federal de subvenciones en bloque destinado a vivienda social. El congreso federal está considerando actualmente un proyecto de ley en el senado que haría desaparecer el programa.

Si Campbell hubiera utilizado un software de Sistema de Información Geográfica (SIG) convencional, hubiera tardado demasiado tiempo en analizar el precio de la vivienda de la ciudad. Pero pudo acceder a la información rápidamente con varias sencillas consultas en PolicyMap, un software excepcional basado en la web que está cambiando la manera en que se adquieren y presentan los datos de planificación. “Si no hubiéramos tenido PolicyMap, sencillamente habríamos rechazado la solicitud”, dice Campbell. “Nos habría tomado demasiado tiempo hacer el trabajo”.

Cuando Campbell hizo su búsqueda en Policy Map, descubrió que el distrito congresual 29, parte del cual está situado en la ciudad de Los Ángeles, era el primero de los 435 distritos congresuales del país en carestía de vivienda en alquiler y el tercero en carestía de vivienda en propiedad. Para el distrito congresual 29, que incluye una gran parte del Valle de San Fernando, esta estadística significa que el 62,9 por ciento de los inquilinos y poco más del 50 por ciento de los propietarios estaban padeciendo una sobrecarga en el precio de la vivienda. “Pensábamos que L.A Sur o L.A. Noreste tendrían una coste de vivienda en alquiler más alto, pero en realidad es el Valle el que lo tiene”, dice Campbell.

Datos públicos para todos

Desde su lanzamiento en 2007, PolicyMap se ha convertido en la mayor base de datos geográficos de la web, y es el recurso de información pública más utilizado por instituciones financieras, universidades, organizaciones sin fines de lucro, y cerca de 2.500 agencias gubernamentales. Esta herramienta en línea tiene en la actualidad más de 37.000 indicadores, que cubren categorías que van desde crimen a acceso a tiendas de comestibles, y facilitan de manera importante el acceso a los datos públicos. El año pasado, el sitio tuvo 434.000 visitantes distintos. La mayor parte de los datos almacenados en PolicyMap es gratuita, pero también se puede obtener acceso a datos privados de varios proveedores por medio de suscripciones de pago. En general, las herramientas de cartografía de PolicyMap son muy fáciles de usar y han ayudado a democratizar el análisis de datos, poniéndolo al alcance de los gobiernos locales y las organizaciones sin fines de lucro, las cuales en general no tienen los recursos necesarios para contratar equipos de especialistas en SIG. El sitio puede servir de ayuda a toda persona involucrada en políticas públicas que no tenga los recursos para acceder de manera independiente a datos digitalizados, evitando la brecha digital.

Una de las características más notables de este sitio web es su capacidad para mostrar simultáneamente distintos tipos de indicadores, como sitios federales de limpieza de contaminación (Superfund), niveles de ingreso por barrio o emprendimientos inmobiliarios financiados con créditos tributarios de vivienda social. Esta capacidad puede facilitar iniciativas de planificación actuales, como los programas Promise Zone o Choice Neighborhood de la administración Obama, que requiere colaboración entre agencias y pone énfasis en la coordinación de distintos tipos de inversiones en áreas de escasos recursos.

PolicyMap también permite a los usuarios trazar la efectividad de programas específicos a lo largo de un periodo de tiempo determinado, ayudándoles a cosechar logros o recortar pérdidas más adelante. Aunque el dinero del gobierno se distribuye principalmente mediante el uso de fórmulas, ha habido un incremento marcado en programas de subvenciones competitivas que requieren informes de progreso y datos que demuestren el detalle de necesidades. En lo que se refiere a subvenciones competitivas, “las ciudades que tienen mejores datos y presentan las propuestas más pulidas, obviamente van a tener ventaja sobre las demás”, según el Presidente y Director Ejecutivo del Instituto Lincoln, George W. McCarthy.

El punto de partida

PolicyMap es una idea del Fondo de Reinversión (The Reinvestment Fund, TRF), una Institución Financiera de Desarrollo Comunitario (Community Development Financial Institution, CDFI) de Filadelfia, que administra un capital de US$839 millones de dólares e invierte en personas y barrios de bajos ingresos. La organización financia una amplia gama de bloques de construcción comunitaria, como viviendas sociales, y guarderías y tiendas de comestibles. PolicyMap nació de la necesidad de TRF de controlar sobre el terreno cómo estaban funcionando estos programas comunitarios.

A principios de la década de 2000, TRF comenzó a explorar maneras de organizar y comprender el impacto de sus propias inversiones. “Estábamos tratando de decidir dónde realizar inversiones a lo largo del tiempo”, dice la presidenta de PolicyMap, Maggie McCullough, en ese entonces investigadora del Departamento de Política de TRF. “También queríamos saber qué tipo de impacto estábamos teniendo y cómo estábamos cambiando los mercados en los que participábamos”.

En 2005, el estado de Pensilvania contrató a TRF para recopilar y organizar una gran cantidad de datos sobre precios de viviendas, ejecuciones hipotecarias e ingresos. El objetivo del proyecto era permitir que los funcionarios pudieran pensar más estratégicamente en cómo utilizar el dinero del estado destinado a vivienda en toda su jurisdicción. Pero aun con un contrato de casi US$200.000, la tarea que podía realizar TRF tenía limitaciones. Los datos y mapas estaban contenidos en un formato fijo en disco. “Después de haber entregado el disco”, dice McCullough, “recuerdo haber pensado que iba a ser como un informe impreso: se iba a guardar en un estante y no se iba a actualizar nunca”.

Esta revelación inspiró a McCullough y otros miembros de TRF a imaginar cómo construir una plataforma cartográfica basada en la web, que permitiera actualizar los datos y a los usuarios cargar sus propias bases de datos. Para desarrollar PolicyMap, McCullough utilizó los conocimientos que adquirió como pionera en el diseño de portales web de información pública. En la década de 1990, fue parte del equipo que construyó el sitio web inicial del Departamento de Vivienda y Desarrollo Urbano (Housing and Urban Development, HUD) de los EE.UU. “Mi experiencia [en] HUD me permitió darme cuenta de que si una persona que no es investigador necesita o quiere comprender datos, tenemos que hacerlos fáciles de comprender”, dice McCullough. “Teníamos que dar nombres normales a los indicadores de datos así como descripciones sencillas, igual que los que teníamos que dar a los programas de HUD”.

McCullough quería que PolicyMap sirviera para todo el país, a diferencia de otras iniciativas de datos que se concentraban en geografías locales. Cuando PolicyMap se lanzó en 2007, “no había realmente ningún SIG en línea”, explica McCullough. “Uno podía obtener instrucciones para llegar a su destino o encontrar un restaurante local con Google Maps, pero gran parte del software SIG estaba encerrado en computadoras de escritorio. Queríamos crear algo a lo que el público pudiera acceder en forma sencilla, a través de la web”.

El primer juego de datos que TRF cargó en PolicyMap en 2007 estaba compuesto por los informes de la Ley de Divulgación de Hipotecas de Vivienda (Home Mortgage Disclosure Act, HMDA), la fuente de datos más importante del gobierno para detectar préstamos abusivos y discriminatorios. En ese momento, la burbuja inmobiliaria se estaba pinchando, y los funcionarios del gobierno y las fuerzas del orden estaban buscando desesperadamente maneras de controlar la incipiente crisis; el primer lugar donde buscarían información eran los datos de HMDA. Pero los datos de HMDA no estaban organizados en un formato adecuado para SIG, con lo cual ciertos tipos de búsqueda eran extremadamente difíciles. Por ejemplo, si un investigador con conocimiento de SIG quería centrarse en una sección de Detroit donde se sospechaba la presencia de una gran cantidad de préstamos de alto costo, no había una herramienta en línea disponible para extraer los datos de HMDA para esa área en particular.

El éxito inicial de PolicyMap para mostrar datos públicos ayudó a atraer a importantes clientes de pago, como la Junta de Reserva Federal en Washington, D.C., que era responsable en ese momento de recopilar los datos de HMDA. Además de cargar todos los datos de HMDA con fines cartográficos y ponerlos a disposición del público en general, el equipo de McCullough construyó una herramienta personalizada de PolicyMap para generar informes para la Reserva Federal, la cual permitió a su personal extraer los datos de HDMA para cualquier localidad de interés. “Facilitamos la tarea [de la Reserva Federal] para acceder a sus propios datos”, dice McCullough.

Un marco de igualdad para todos

Los grandes prestamistas e inversores inmobiliarios generalmente se suscriben a juegos de herramientas que pueden alcanzar precios de seis cifras para acceder a servicios que brindan información exclusiva, como informes de valuación de propiedades e investigaciones detalladas de mercado. Pero muchas organizaciones comunitarias y gobiernos locales no tienen los recursos para comprar estos datos bajo licencia. Y aunque pudieran pagar estas suscripciones tan caras, muchas organizaciones comunitarias y gobiernos locales no tendrían el personal o la capacidad de SIG para usarlas en mapas interactivos.

Considérese, por ejemplo, NeighborWorks, una red nacional de 240 organizaciones comunitarias que no tiene un especialista en SIG. Harry Segal, un especialista en gestión y planificación de NeighborWorks America, dice que PolicyMap ha cambiado la ecuación para su red, al darle acceso a datos y herramientas cartográficas que de otra manera no podrían pagar. “Cualquier emprendedor inmobiliario, ya sea público o privado, que quiera comenzar a trabajar en un barrio nuevo tiene que cortejar a los poderes establecidos y demostrar un conocimiento de las condiciones del mercado de la zona”, dice Segal. “Para organizaciones sin fines de lucro, es mucho más difícil compilar este tipo de datos”. Sin PolicyMap, dice, “casi no vale la pena exprimir el jugo”.

La suscripción a PolicyMap de NeighborWorks, que cuesta US$5.000 al año, brinda acceso a este tipo de datos exclusivos y permite a los miembros de la organización realizar consultas sobre distintas secciones de un mapa para obtener información sobre una variedad de indicadores, como el ingreso promedio de los residentes de determinado barrio y el nivel de hipotecas de alto costo otorgadas en la zona. Esta capacidad para analizar a distintas escalas geográficas empodera a los grupos comunitarios locales que están tratando de acceder a financiación o llamar la atención sobre préstamos abusivos en sus barrios. “Tenemos un par de organizaciones en el norte del estado de Nueva York. Si uno busca estadísticas sobre esa región, van a estar distorsionadas por la dominancia de la Ciudad de Nueva York”, dice Segal. “Pero con PolicyMap, podemos extraer datos por distrito o división censal”.

Algunas agencias municipales tampoco tienen capacidad para diseñar o mantener los tipos de bases de datos a los que ahora pueden acceder por medio de una suscripción a PolicyMap. “Soy la única persona aquí que sabe de SIG”, dice Sara Eaves, analista de planificación y política para la Autoridad de Vivienda de San Antonio. Agrega que PolicyMap permite a muchas personas de su oficina realizar tareas que de otra manera exigirían una capacitación especializada. Con su suscripción a PolicyMap, la Autoridad de Vivienda de San Antonio también puede publicar datos sobre escuelas, tasas de vacancia residencial, niveles de ingreso en los barrios y otras informaciones que un residente municipal podría considerar al decidir dónde comprar una casa o alquilar un apartamento. “Podríamos mantener bases de datos similares en nuestra agencia, pero no tenemos los recursos. PolicyMap nos permitió poner mapas interactivos en nuestro sitio web, con lo cual no sólo disponemos de información internamente sino que también la ponemos al alcance del público en general”.

Racionalizar el proceso para las ciudades y los grupos comunitarios

Muchos analistas políticos usan un software SIG tradicional, como Esri, y además las herramientas SIG simplificadas disponibles en PolicyMap. Campbell, del Departamento de Vivienda y Desarrollo Comunitario de Los Ángeles, dice que Esri ofrece la capacidad de hacer pronósticos y realizar ciertos tipos de análisis complejos que no son posibles con PolicyMap. Pero señala que PolicyMap le ahorra tiempo y le permite explicar más fácilmente sus investigaciones a personas sin conocimientos especializados. “Me gusta PolicyMap porque se basa en datos concretos y es irrefutable”, dice, mientras que Esri contiene predicciones sobre el futuro. “A veces, cuando uno entrega un informe de análisis comunitario con datos de Esri, hay demasiada información para digerir. Habrá información sobre 2005, 2010 y 2015. Pero para la información de 2020 hay una fórmula de cómo crearon el pronóstico, que quizás no sea necesaria y puede estar equivocada”.

PolicyMap también es lo suficientemente flexible como para responder a las necesidades cambiantes de los usuarios. A medida que los requisitos de datos han aumentado y se han hecho más complejos, los clientes de PolicyMap de hace muchos años han pedido nuevas herramientas para ayudar a mejorar la eficiencia. Por ejemplo, Melissa Long, subdirectora de la Oficina de Vivienda y Desarrollo Comunitario de Filadelfia, había estado usando PolicyMap para mostrar datos de censo agregados y simplificados. Pero hace varios años se dio cuenta de que su agencia necesitaba herramientas analíticas más exhaustivas para poder solicitar una cantidad creciente de subvenciones por licitación.

“Necesitábamos una gran cantidad de información demográfica vecinal y conocer qué tipos de programas municipales se estaban implementando”, dice Long, señalando que los datos municipales disponibles de PolicyMap han mejorado la coordinación entre las distintas agencias municipales y también el posicionamiento de la ciudad para solicitar subvenciones competitivas.

Long dice que las herramientas desarrolladas por PolicyMap para Filadelfia permitirán que la ciudad controle su progreso en una Subvención de Implementación de Choice Neighborhoods, que respalda estrategias locales para barrios que tienen problemas con viviendas públicas o asistidas por HUD. “La subvención cubre un periodo de cinco años. Si vemos que nuestra propuesta de estabilización de barrios no está funcionando”, dice, “podemos realizar correcciones a la subvención a medio camino”.

La posibilidad de analizar distintos tipos de datos simultáneamente también permite a los investigadores trazar los beneficios compartidos de una inversión en particular. Por ejemplo, en Filadelfia hay dos programas distintos de limpieza y reverdecimiento de lotes vacantes. PolicyMap permite que los usuarios vean los lotes rehabilitados por ambos programas simultáneamente, y estudiar si han mejorado la calidad de vida en los barrios circundantes. El contrato de Filadelfia con PolicyMap ha permitido superponer datos de múltiples estudios, como el de la Escuela Wharton de la Universidad de Pensilvania, que mostró cómo los valores inmobiliarios crecieron un 17 por ciento en promedio alrededor de los lotes embellecidos, y otro que mostró como los delitos a mano armada disminuyeron significativamente en dichas zonas. Un tercer co-beneficio son los cientos de puestos de trabajo de verano que se necesitan para mantener estos lotes rehabilitados. “No se puede analizar solamente la vivienda”, dice Long. Hay que considerar “todas las demás cosas que pasan en un barrio”.

Una de las herramientas analíticas más populares de PolicyMap es el Análisis de Valor de Mercado (Market Value Analysis, MVA), que TRF desarrolló para Filadelfia y después fue reproducido en alrededor de 18 ciudades más. MVA analiza la fortaleza de las distintas áreas de la ciudad mostrando secciones codificadas en color de un mapa de valores asignados, que van desde “Problemáticos” a “Selección Regional”, que es la clasificación más alta. Esta clasificación se realiza usando una técnica llamada análisis de conglomerados, que evalúa divisiones censales de acuerdo con grupos de indicadores tales como actividades de venta de casas, tasas de vacancia y ejecuciones hipotecarias. Si se hace clic en cualquier sección del mapa, aparece una tabla con los datos utilizados para determinar la clasificación de esa área específica. Los barrios clasificados como Selección Regional, dice McCullough, en general tienen buenas ventas, bajas tasas de vacancia y se combinan los propietarios y los inquilinos.

Estos MVA proporcionan a las agencias gubernamentales y organizaciones sin fines de lucro la información que necesitan para abordar los problemas específicos de la zona, dice McCarthy, del Instituto Lincoln. “Siempre se desea el mejor rendimiento posible para una inversión de dinero público”, dice. “En los barrios realmente problemáticos, ello puede significar invertir en demolición a gran escala para acelerar la reutilización de las propiedades. En un barrio en transición, se podrían comprar casas abandonadas y arreglarlas”.

El camino a seguir

El equipo de PolicyMap publica frecuentemente nuevos índices y herramientas inmediatamente después de decisiones judiciales y dictámenes de organismos. El mes de julio pasado, por ejemplo, McCullough y su equipo publicaron el índice de Áreas Raciales y Étnicamente Concentradas de Pobreza (Racially and Ethnically Concentrated Areas of Poverty, RCAP/ECAP), que se usa para identificar distritos censales de los EE.UU. que tienen una gran proporción de individuos no caucásicos y gente que vive por debajo del umbral de pobreza. McCullough dice que su equipo anticipó el dictamen de la Corte Suprema en junio sobre “impacto desigual” en prácticas de vivienda y, varios meses antes, comenzó a elaborar el índice para ayudar a individuos y organizaciones a comprender los temas relacionados con la decisión de la corte. “La sincronización fue perfecta”, dice. “Cuando se produjo [el dictamen de la Corte Suprema], estábamos listos para actuar”.

PolicyMap todavía no cuenta con juegos de datos importantes que McCullough quisiera tener para ayudar a los investigadores a comprender mejor los temas críticos que enfrenta el país. Por ejemplo, McCullough siempre quiso incorporar los datos nacionales de ejecución hipotecaria como parte de los esfuerzos de PolicyMap para efectuar el seguimiento de los factores que influyen en los precios de venta inmobiliaria, pero es difícil encontrar juegos de datos integrales y fidedignos sobre ejecución hipotecaria. Además, la compra de licencias de datos de ejecución hipotecaria de proveedores privados es excesivamente cara. Los clientes de PolicyMap también expresaron interés en acceder a los historiales de crédito, y estos son datos muy difíciles de obtener. “No pudimos siquiera obtener permiso de las agencias de crédito para la licencia de datos”, dice McCullough. “Y si pudiéramos obtener sus datos, estarían agrupados a una escala geográfica muy grande, de estado”.

Mientras tanto, PolicyMap recibirá uno de los mayores suministros de datos en octubre, con la primera parte de un proyecto provisionalmente titulado “Estado del suelo en el país”, subsidiado por el Instituto Lincoln. El “Estado del suelo en el país” incluirá una colección de 18 bases de datos enormes de 150 agencias gubernamentales distintas, que cubrirá criterios tales como sitios altamente contaminados, inversiones públicas en suelos, zonas de inundación e información de zonificación.

El proyecto del Instituto Lincoln pretende ayudar a las agencias gubernamentales a mejorar su tarea y brindar al ciudadano común herramientas con las que puedan pedir rendición de cuentas a los funcionarios electos. Debería arrojar más luz sobre algunos de los problemas más complejos del país, como la persistencia de la pobreza en ciertas áreas o la discriminación inversa, cuando se atrae a consumidores minoritarios para ofrecerles préstamos en términos no favorables. En última instancia —como con el descubrimiento de que el Valle de San Fernando es el lugar más caro para vivir en el país si se consideran los ingresos locales de los residentes—, no podemos anticipar algunos de los hechos y tendencias más interesantes que se descubrirán en el futuro, sino a medida que los investigadores vayan aprendiendo a navegar por PolicyMap.

“Cada vez que uso PolicyMap, empiezo a ver cosas distintas”, dice McCarthy. “Hay un proceso completo de descubrimiento que se abre, y es muy iluminador”.

Alex Ulam es un periodista enfocado en temas de arquitectura, arquitectura paisajista, y temas de planificación urbana y vivienda.

La Bahía de Chesapeake es un icono cultural, un tesoro nacional y un recurso natural protegido por cientos de agencias, organizaciones sin fines de lucro e instituciones. Ahora, una nueva tecnología de construcción de mapas digitales con exactitud sin precedentes, desarrollada por The Chesapeake Conservancy y respaldada por el Instituto Lincoln de Políticas de Suelo, está identificando con precisión contaminación y otras amenazas a la salud del ecosistema de la bahía y su cuenca, que abarca 165.000 km2, 16.000 km de costa y 150 ríos y arroyos importantes. Con una resolución de un metro por un metro, la tecnología de mapas de “conservación de precisión” está llamado la atención de una amplia gama de agencias e instituciones, que ven aplicaciones potenciales para una variedad de procesos de planificación en los Estados Unidos y el resto del mundo. Este nuevo juego de datos de cubierta de suelo, creado por el Centro de Innovación de Conservación (CIC) de The Conservancy, tiene 900 veces más información que los juegos de datos anteriores y brinda mucho más detalle sobre los sistemas naturales y las amenazas medioambientales a la cuenca, de las que la más persistente y urgente es la contaminación de las aguas de la bahía, que afecta desde la salud de la gente, las plantas y la vida silvestre hasta la industria pesquera, el turismo y la recreación.

“El gobierno de los EE.UU. está invirtiendo más de US$70 millones al año para limpiar la Bahía de Chesapeake, pero no sabe qué intervenciones tienen el mayor impacto”, dice George W. McCarthy, presidente y director ejecutivo del Instituto Lincoln. “Con esta tecnología podremos determinar si las intervenciones pueden interrumpir el flujo superficial de nutrientes que está provocando el florecimiento de algas en la bahía. Podremos ver dónde fluye el agua a la Bahía de Chesapeake. Podremos ver el rédito del dinero invertido, y podremos comenzar a reorientar a la Agencia de Protección Ambiental (EPA, por su sigla en inglés), el Departamento de Agricultura y múltiples agencias que quizás planifiquen en forma estratégica pero sin comunicarse entre sí”.

The Chesapeake Conservancy, una organización sin fines de lucro, está dando los toques finales a un mapa de alta resolución de toda la cuenca para el Programa de la Bahía de Chesapeake. Ambas organizaciones están ubicadas en Annapolis, Maryland, el epicentro de los esfuerzos de conservación de la bahía. El programa presta servicio a la Asociación de la Bahía de Chesapeake (Chesapeake Bay Commission), la EPA, la Comisión de la Bahía de Chesapeake y los seis estados que alimentan la cuenca: Delaware, Maryland, Nueva York, Pensilvania, Virginia, West Virginia y el Distrito de Columbia, junto con 90 contrapartes más, entre las que se cuentan organizaciones sin fines de lucro, instituciones académicas y agencias gubernamentales como la Administración Nacional Oceánica y Atmosférica, el Servicio de Peces y Vida Silvestre de los EE.UU., el Servicio Geológico de los EE.UU. (USGS) y el Departamento de Defensa de los EE.UU.

En nombre de esta alianza, la EPA invirtió US$1,3 millones en 2016 en financiamiento estatal y federal para el proyecto de cubierta de suelo de alta resolución de The Conservancy, que se está desarrollando en conjunto con la Universidad de Vermont. La información obtenida de los diversos programas piloto de mapas de precisión ya está ayudando a los gobiernos locales y contrapartes fluviales a tomar decisiones de gestión de suelo más eficientes y económicas.

“Hay muchos actores en la cuenca de la Bahía de Chesapeake”, dice Joel Dunn, presidente y director ejecutivo de The Chesapeake Conservancy. “La comunidad ha estado trabajando en un problema de conservación muy complicado por los últimos 40 años, y como resultado hemos creado capas y capas y muchas instituciones para resolver este problema”.

“Ahora no es un problema de voluntad colectiva sino un problema de acción, y toda la comunidad tiene que asociarse de maneras más innovadoras para llevar la restauración de los recursos naturales de la cuenca al próximo nivel superior”, agrega.

“La tecnología de conservación está evolucionando rápidamente y puede estar llegando ahora a su cima”, dice Dunn, “y queremos montarnos sobre esa ola”. El proyecto es un ejemplo de los esfuerzos de The Conservancy para llevar su trabajo a nuevas alturas. Al introducir “big data” (datos en gran volumen) en el mundo de la planificación medioambiental, dice, The Conservancy se preparar para innovar como un “emprendedor de conservación”.

¿Qué es la tecnología de mapas de precisión?

Los datos del uso del suelo y la cubierta del suelo (LULC, por su sigla en inglés) extraídos de imágenes por satélite o desde aviones son críticos para la gestión medioambiental. Se usa para todo, desde mapas de hábitat ecológico hasta el seguimiento de tendencias de desarrollo inmobiliario. El estándar de la industria es la Base de Datos Nacional de Cubierta de Suelo (NLCD, por su sigla en inglés) de 30 m por 30 m de resolución del USGS, que proporciona imágenes que abarcan 900 m2, o casi un décimo de hectárea. Esta escala funciona bien para grandes áreas de terreno. No es suficientemente exacta, sin embargo, para proyectos de pequeña escala, porque todo lo que tenga un décimo de hectárea o menos se agrupa en un solo tipo de clasificación de suelo. Una parcela podría ser clasificada como un bosque, por ejemplo, pero ese décimo de hectárea podría tener también un arroyo y humedales. Para maximizar las mejoras en la calidad del agua y los hábitats críticos, hacen falta imágenes de mayor resolución para poder tomar decisiones a nivel de campo sobre dónde vale la pena concentrar los esfuerzos.

Con imágenes aéreas públicamente disponibles del Programa Nacional de Imágenes de Agricultura (NAIP, por su sigla en inglés), en combinación con datos de elevación del suelo de LIDAR (sigla en inglés de Detección y Medición de Distancia por Luz), The Conservancy ha creado juegos de datos tridimensionales de clasificación del suelo con 900 veces más información y un nivel de exactitud de casi el 90 por ciento, comparado con el 78 por ciento para la NLCD. Esta nueva herramienta brinda una imagen mucho más detallada de lo que está ocurriendo en el suelo, identificando puntos donde la contaminación está ingresando en los arroyos y ríos, la altura de las pendientes, y la efectividad de las mejores prácticas de gestión (Best Management Practices, o BMP), como sistemas de biofiltración, jardines de lluvia y amortiguadores forestales.

“Podemos convertir las imágenes vírgenes en un paisaje clasificado, y estamos entrenando a la computadora para que vea lo mismo que los seres humanos al nivel del terreno”, incluso identificando plantas individuales, dice Jeff Allenby, Director de Tecnología de Conservación, quien fue contratado en 2012 para aprovechar la tecnología para estudiar, conservar y restaurar la cuenca. En 2013, una subvención de US$25.000 del Consejo de Industrias de Tecnología Informática (ITIC) permitió a Allenby comprar dos computadoras poderosas para comenzar el trabajo de trazar mapas digitales. Con el respaldo del Programa de la Bahía de Chesapeake, su equipo de ocho expertos en sistemas de información geográfica (SIG) ha creado un sistema de clasificación para la cuenca de la Bahía de Chesapeake con 12 categorías de cubierta de suelo, como superficies impermeables, humedales, vegetación de baja altura y agua. También está incorporando información de zonificación de los usos del suelo provista por el Programa de la Bahía de Chesapeake.

El potencial de la tecnología

El trazado de mapas de precisión “tiene el potencial de transformar la manera de ver y analizar sistemas de suelo y agua en los Estados Unidos”, dice James N. Levitt, Gerente de Programas de Conservación de Suelo del Departamento de Planificación y Forma Urbana del Instituto Lincoln, que está respaldando el desarrollo tecnológico de The Conservancy con una subvención de US$50.000. “Nos ayudará a mantener la calidad del agua y los hábitats críticos, y ubicar las áreas donde las actividades de restauración pueden tener el mayor impacto sobre el mejoramiento de la calidad del agua”. Levitt dice que la tecnología permite convertir fuentes de contaminación “no puntuales”, o sea difusas e indeterminadas, en fuentes “puntuales” identificables específicas sobre el terreno. Y ofrece un gran potencial de uso en otras cuencas, como la de los sistemas de los ríos Ohio y Mississippi, los que, como la cuenca de Chesapeake, también tienen grandes cargas de escurrimiento contaminado de aguas de tormenta debido a actividades agrícolas.

Es un momento propicio para hacer crecer la tecnología de conservación en la región de Chesapeake. En febrero de 2016, la Corte Suprema de los EE.UU. decidió no innovar en un caso que disputaba el plan de la Asociación de la Bahía de Chesapeake para restaurar plenamente la bahía y sus ríos de marea, para poder volver a nadar y pescar en ellos para 2025. Esta decisión de la Corte Suprema dejó en su lugar un dictamen de la Corte de Apelación del 3.er Circuito de los EE.UU. que confirmó el plan de aguas limpias y mayores restricciones sobre la carga máxima total diaria, o el límite de contaminación permisible de sustancias como nitrógeno y fósforo. Estos nutrientes, que se encuentran en los fertilizantes agrícolas, son los dos contaminantes principales de la bahía, y son tenidos en cuenta bajo las normas federales de calidad del agua establecidas en la Ley de Agua Limpia. El dictamen también permite a la EPA y a agencias estatales imponer multas a aquellos que contaminan y violan las reglamentaciones.

La calidad del agua de la Bahía de Chesapeake ha mejorado desde su fase de mayor contaminación en la década de 1980. Las modernizaciones y la explotación más eficiente de las plantas de tratamiento de aguas servidas han reducido la cantidad de nitrógeno que ingresa en la bahía en un 57 por ciento, y el fósforo en un 75 por ciento. Pero los estados de la cuenca siguen violando las regulaciones de agua limpia y el aumento del desarrollo urbano exige una evaluación constante y una reducción de la contaminación en el agua y hábitats críticos.

Proyecto piloto núm. 1: El río Chester

The Conservancy completó una clasificación de suelo de alta resolución y análisis de escurrimiento de aguas de tormenta para toda la cuenca del río Chester, en la costa oriental de Maryland, con financiamiento de las Campañas de Energía Digital y Soluciones de Sostenibilidad de ITIC. Isabel Hardesty es la cuidadora del río Chester, de 100 km de largo, y trabaja con la Asociación del río Chester, con asiento en Chestertown, Maryland. (“Cuidadora de río” es el título oficial de 250 individuos en todo el mundo que son los “ojos, oídos y voz” de un cuerpo de agua.) El análisis de The Conservancy ayudó a Hardesty y su personal a comprender dónde fluye el agua a través del terreno, dónde serían más efectivos las BMP y qué corrientes fluviales degradadas sería mejor restaurar.

Dos tercios de la cubierta del suelo en la cuenca del río Chester son cultivos en hilera. Los agricultores de estos cultivos frecuentemente usan fertilizante en forma uniforme en todo el campo, y el fertilizante se escurre con las aguas de tormenta de todo el predio. Esto se considera contaminación no puntual, lo cual hace más difícil identificar el origen exacto de los contaminantes que fluyen a un río, comparado, por ejemplo, con una pila de estiércol. El equipo de The Conservancy trazó un mapa de toda la cuenca del río Chester, identificando dónde llovió en el terreno y dónde fluyó el agua.

“A simple vista se puede mirar un campo y ver dónde fluye el agua, pero este análisis es mucho más científico”, dice Hardesty. El mapa mostró la trayectoria del flujo de agua en toda la cuenca, en rojo, amarillo y verde. El color rojo identifica un mayor potencial de transporte de contaminantes, como las trayectorias de flujo sobre superficies impermeables. El color verde significa que el agua está filtrada, como cuando fluye a través de humedales o un amortiguador forestal, reduciendo la probabilidad de que transporte contaminantes. El amarillo es un nivel intermedio, que indica que podría ser uno u otro. El análisis se tiene que “comprobar en la realidad”, dice Hardesty, o sea que el equipo usa análisis SIG a nivel de cada granja para confirmar lo que está ocurriendo en un campo específico.

“Somos una organización pequeña y tenemos relaciones con la mayoría de los agricultores de la zona”, dice Hardesty. “Podemos mirar una parcela de terreno y saber qué prácticas está usando el agricultor. Nos hemos comunicado con nuestros terratenientes y colaborado con ellos en sus predios; así sabemos dónde pueden entrar contaminantes a los arroyos. Cuando nos enteramos de que un agricultor en particular quiere poner un humedal en su granja, su uso del suelo y el análisis de flujo de agua nos ayuda a determinar qué tipo de BMP tenemos que usar y dónde tiene que estar ubicado”. El valor de elaborar mapas de precisión para la Asociación del Río Chester, dice Hardesty, ha sido “poder darse cuenta que el mejor lugar para colocar una solución de intercepción de agua es donde sea mejor para el agricultor. En general, esta es una parte bastante poco productiva de la granja”. Dice que en general los agricultores están contentos de poder trabajar con ellos para resolver el problema.

La Asociación del Río Chester también está desplegando tecnología para usar los recursos de modo más estratégico. La organización tiene un programa de monitorización de agua y ha recolectado datos sobre la cuenca por muchos años, que el equipo de The Conservancy ha analizado para clasificar los arroyos de acuerdo a su calidad de agua. La asociación ha hecho ahora análisis SIG que muestra los trayectos de flujo para todas las subcuencas de arroyos, y está creando un plan estratégico para guiar los esfuerzos futuros de limpieza de los arroyos con la peor calidad del agua.

Proyecto piloto núm. 2: Herramienta de informe de BMP del Consorcio de Aguas de Tormenta del Condado de York

En 2013, The Conservancy y otras contrapartes principales lanzaron el programa Envision the Susquehanna (Vislumbrar el Susquehanna) para mejorar la integridad ecológica y cultural del paisaje y la calidad de vida a lo largo del río Susquehanna, desde su cabecera en Cooperstown, Nueva York, hasta su descarga en la Bahía de Chesapeake en Havre de Grace, Maryland. En 2015, The Conservancy seleccionó el programa para su proyecto piloto de datos en el condado de York, Pensilvania.

Pensilvania ha tenido problemas para demostrar progreso en la reducción del escurrimiento de nitrógeno y sedimento, sobre todo en los lugares donde las aguas de tormenta urbanas ingresan en los ríos y arroyos. En 2015 la EPA anunció que iba a retener US$2.9 millones de fondos federales hasta que el estado pudiera articular un plan para alcanzar sus metas. En respuesta, el Departamento de Protección Ambiental de Pensilvania publicó su Estrategia de restauración de la Bahía de Chesapeake para aumentar el financiamiento de proyectos de aguas de tormenta locales, verificar el impacto y los beneficios de BMP locales, y mejorar la contabilidad y recolección de datos para supervisar su efectividad.

El condado de York creó el Programa de Reducción de Contaminación de la Bahía de Chesapeake – Condado de York para coordinar los informes sobre proyectos de limpieza. La tecnología de mapas de precisión de The Conservancy ofreció una oportunidad perfecta para un proyecto piloto: En la primavera de 2015, la Comisión de Planificación del Condado de York y The Conservancy comenzaron a colaborar para mejorar el proceso de selección de los proyectos de BMP para escurrimiento de aguas de tormenta urbana, que cuando se combinan con un aumento de los emprendimientos inmobiliarios, constituyen la amenaza de mayor crecimiento en la Bahía de Chesapeake.

La comisión de planificación seleccionó el proceso de propuesta anual de BMP de 49 de las 72 municipalidades reguladas como “sistemas de alcantarillado de aguas de tormenta municipales separados”, o MS4, por su sigla en inglés. Estos son sistemas de aguas de tormenta requeridos por la Ley de Agua Limpia federal para recolectar el escurrimiento contaminado que de lo contrario fluiría a las vías fluviales locales. La meta de la comisión era normalizar el proceso de presentación y revisión de proyectos. El condado descubrió que las reducciones de carga calculadas no eran correctas en varias municipalidades, porque no contaban con el personal necesario para recolectar y analizar los datos, o usaron una variedad de fuentes de datos distintas. Por consiguiente, a la comisión le resultó difícil identificar, comparar y elaborar prioridades para identificar los proyectos más efectivos y económicos para alcanzar las metas de calidad de agua.

Cómo usar la herramienta de informe de BMP del Consorcio de Aguas de Tormenta del Condado de York

Para usar la herramienta en línea, los usuarios seleccionan un área de proyecto propuesta, y la herramienta genera automáticamente un análisis de la cubierta del suelo de alta resolución para toda el área de drenaje del proyecto. La herramienta integra estos datos de alta resolución, por lo que los usuarios pueden evaluar cómo sus proyectos podrían interactuar con el paisaje. Los usuarios también pueden comparar proyectos potenciales de manera rápida y fácil, y después revisar y presentar propuestas de proyectos con el mayor potencial para mejorar la calidad del agua. Los usuarios después pueden ingresar la información del proyecto en un modelo de reducción de carga de nutrientes/sedimentos llamado Herramienta de escenario de evaluación de instalaciones de la Bahía, o BayFAST. Los usuarios ingresan información adicional sobre el proyecto, y la herramienta inserta los datos geográficos. El resultado es un informe simple de una página en formato PDF que reseña los costos estimados del proyecto por libra de nitrógeno, fósforo y reducción de sedimento. Puede usar la herramienta en: http://chesapeakeconservancy.org/apps/yorkdrainage.

The Conservancy y la comisión de planificación colaboraron para elaborar una Herramienta de informe de BMP del Consorcio de Aguas de Tormenta del Condado de York de fácil utilización (recuadro, pág. 14), que permite comparar distintos métodos de restauración y cambio en el uso del suelo, y analizarlos antes de ponerlos en práctica. The Conservancy, la comisión y los miembros del personal municipal colaboraron sobre una plantilla uniforme de propuestas y recolección de datos, y optimizaron el proceso con los mismos juegos de datos. Después, The Conservancy capacitó a algunos profesionales SIG locales para que ellos a su vez pudieran proporcionar asistencia técnica a otras municipalidades.

“Se puede usar en forma fácil y rápida”, explica Gary Milbrand, CFM, el ingeniero SIG y Director de Informática de la Municipalidad de York, quien proporciona asistencia técnica de proyecto a otras municipalidades. Anteriormente, dice, las municipalidades típicamente gastaban entre US$500 y US$1.000 en consultores para analizar sus datos y crear propuestas e informes. La herramienta de informe, dice, “nos ahorra tiempo y dinero”.

La comisión requirió a todas las municipalidades reguladas que presentaran sus propuestas de BMP usando la nueva tecnología para el 1 de julio de 2016, y las propuestas de financiamiento se seleccionarán a fines de este otoño. Las contrapartes dicen que las municipalidades están más involucradas en el proceso de describir cómo sus proyectos están funcionando en el entorno, y esperan ver proyectos más competitivos en el futuro.

“Por primera vez podemos hacer una comparación cuantitativa”, dice Carly Dean, gerente de proyecto de Envision the Susquehanna. “El solo hecho de poder visualizar los datos permite que el personal municipal analice cómo interactúan sus proyectos con el terreno, y por qué el trabajo que están realizando es tan importante”. Dean agrega: “Sólo estamos empezando a escarbar la superficie. Pasará un tiempo hasta poder darnos cuenta de todas las aplicaciones potenciales”.

Integración de datos de la cubierta del suelo y el uso del suelo a nivel de parcela

El equipo de Conservación también está trabajando para superponer datos de cubierta de suelo con los datos de condado a nivel de parcela, para proporcionar más información sobre cómo se está usando el suelo. La combinación de imágenes satelitales de alta resolución y datos del uso del suelo del condado a nivel de parcela no tiene precedentes. Los condados construyen y mantienen bases de datos a nivel de parcela en todos los Estados Unidos utilizando información como registros tributarios y de propiedad. Alrededor de 3.000 de los 3.200 condados han digitalizado estos registros públicos. Pero aun así, en muchos de estos condados los registros no se han organizado y normalizado para el uso del público, dice McCarthy.

La EPA y un equipo de USGS en Annapolis han estado combinando datos de la cubierta de suelo de un metro de resolución con datos del uso del suelo para los seis estados de Chesapeake, para brindar una vista amplia a nivel de cuenca que al mismo tiempo proporcione información detallada sobre el suelo desarrollado y rural. Este otoño, el equipo incorporará los datos del uso del suelo y la cubierta del suelo de cada ciudad y condado, y realizará ajustes para confirmar que los datos de los mapas de alta resolución coincidan con los datos a escala local.

Los datos actualizados del uso del suelo y la cubierta del suelo se cargarán luego en el Modelo de la Cuenca de la Bahía de Chesapeake, un modelo de computadora que se encuentra actualmente en el nivel 3 de sus 4 versiones de pruebas beta de producción y revisión. Las contrapartes estatales y municipales, distritos de conservación y otras contrapartes de la cuenca han revisado cada versión y sugerido cambios en función de su experiencia de mitigación de aguas de tormenta, modernizaciones de tratamiento de aguas y otras BMP. Los datos detallarán, por ejemplo, el desarrollo de uso mixto, distintos usos del suelo agrícola para cultivos, alfalfa y pastura; y mediciones tales como la producción de fruta o verduras del suelo. Aquí es donde la conversión de la cubierta del suelo al uso del suelo es útil para ayudar a especificar las tasas de carga de contaminación.

“Queremos un proceso muy transparente”, dice Rich Batiuk de la EPA, director asociado de ciencia, análisis e implementación del Programa de la Bahía de Chesapeake, señalando que los datos combinados de la cubierta del suelo y el uso del suelo se podrán acceder en línea sin cargo. “Queremos miles de ojos sobre los datos de uso y cubierta del suelo. Queremos ayudar a las contrapartes estatales y locales con datos sobre cómo lidiar con bosques, llanuras de inundación, arroyos y ríos. Y queremos mejorar el producto para poder obtener un modelo de simulación de políticas de control de la contaminación en toda la cuenca”.

Ampliación del trabajo y otras aplicaciones

A medida que la tecnología se refina y es utilizada más ampliamente por las contrapartes de la cuenca, The Conservancy espera poder crear otros juegos de datos, ampliar el trabajo a otras aplicaciones, y realizar actualizaciones anuales o bianuales para que los mapas sean siempre un reflejo de las condiciones reales. “Estos datos son importantes como una línea de base, y veremos cuál es la mejor manera de evaluar los cambios que se producen con el tiempo”, dice Allenby.

Las contrapartes de la cuenca están discutiendo aplicaciones adicionales para los juegos de datos de un metro de resolución, desde actualizar los mapas de emergencia/911, a proteger especies en extinción, a desarrollar servidumbres y comprar suelo para organizaciones de conservación. Más allá de la Bahía de Chesapeake, el trazado de mapas de precisión podría ayudar a realizar proyectos a escala de continente. Es el símil para la conservación de la agricultura de precisión, que permite determinar, por ejemplo, dónde se podría aplicar un poco de fertilizante para maximizar el beneficio para las plantas. Cuando se combinan estos dos elementos, la producción de alimentos puede crecer y reducir al mismo tiempo el impacto medioambiental de la agricultura. La tecnología también podría ayudar con prácticas de desarrollo más sostenible, el aumento del nivel del mar, y la resiliencia.

Mucha gente creyó que una pequeña organización sin fines de lucro no podía encarar este tipo de análisis, dice Allenby, pero su equipo pudo hacerlo por un décimo del costo estimado. El próximo paso sería poner estos datos del uso del suelo y la cubierta del suelo a disposición del público sin cargo. Pero en este momento eso sería muy oneroso. Los datos necesitan copias de respaldo, seguridad y una enorme cantidad de espacio de almacenamiento. El equipo de The Conservancy está transfiriendo los datos en colaboración con Esri, una compañía de Redlands, California, que vende herramientas de trazado de mapas por SIG, y también Microsoft Research y Hexagon Geospatial. El proceso se ejecuta en forma lineal, un metro cuadrado por vez. En un sistema que se ejecuta en la nube, se puede procesar un kilómetro cuadrado por vez y distribuir a 1.000 servidores por vez. Según Allenby, ello permitiría hacer un mapa a nivel de parcela de los 8,8 millones de kilómetros cuadrados de los EE.UU. en un mes. Sin esta tecnología, 100 personas tendrían que trabajar durante más de un año, a un costo mucho mayor, para producir el mismo juego de datos.

Los mapas de precisión podrían aportar mucho más detalle a State of the Nation’s Land, un periódico anual en línea de bases de datos sobre el uso y la propiedad del suelo que el Instituto Lincoln está produciendo con PolicyMap. McCarthy sugiere que la tecnología podría responder a preguntas tales como: ¿Quién es el dueño de los Estados Unidos? ¿Cómo estamos usando el suelo? ¿Cómo afecta la propiedad el uso del suelo? ¿Cómo está cambiando con el tiempo? ¿Cuál es el impacto de los caminos desde el punto de vista ambiental, económico y social? ¿Qué cosas cambian después de construir un camino? ¿Cuánto suelo rico para la agricultura ha estado enterrado debajo de los emprendimientos suburbanos? ¿Cuándo comienza a tener importancia? ¿Cuánto suelo estamos despojando? ¿Qué pasa con nuestro suministro de agua?

“¿Puede resolver problemas sociales grandes?”, pregunta McCarthy. Una de las consecuencias más importantes de la tecnología de mapas de precisión sería encontrar mejores maneras de tomar decisiones sobre las prácticas del uso del suelo, dice, sobre todo en la interfaz entre la gente y el suelo, y entre el agua y el suelo. Se necesitan los registros de suelo para usar esta tecnología más eficazmente, lo cual podría presentar un desafío en algunos lugares porque no hay registros, o los que hay no son sistemáticos. Pero es una metodología y tecnología que se puede usar en otros países, dice. “Es un cambio en las reglas del juego, permitiéndonos superponer datos del uso del suelo con datos de la cobertura del suelo, lo cual puede ser increíblemente valioso para lugares de urbanización rápida, como China y África, donde los patrones y cambios se podrán observar sobre el suelo y con el correr del tiempo. Es difícil exagerar su impacto”.

“Nuestro objetivo es usar esta tecnología para aumentar la transparencia y la rendición de cuentas en todo el mundo”, dice McCarthy. “Cuanto más información puedan acceder los planificadores, mejor podrán defender nuestro planeta”. La herramienta se debería compartir con la “gente que quiere usarla con el fin apropiado, de manera que estamos haciendo la propuesta de valor de que este es un bien público que todos debemos mantener”, dice, en forma similar a cómo USGS desarrolló el sistema SIG.

“Necesitamos la alianza pública-privada apropiada, algo así como un servicio público regulado, con supervisión y respaldo público, que se mantenga como un bien público”.

Kathleen McCormick, fundadora de Fountainhead Communications, LLC, vive y trabaja en Boulder, Colorado, y escribe frecuentemente sobre comunidades sostenibles, saludables y resilientes.

Crédito: The Chesapeake Conservancy